2024年10月28日

Linuxからリモートデスクトップ

目次: Linux

開発用のLinuxマシンの画面を見るにはいろいろな手段がありますが、最近はxrdpを使っています。WindowsからもLinuxからもリモートデスクトップで接続できて、同じ画面を拝めるので便利です。以前はTigerVNCを使っていましたが、Windows版のクライアントはVNC系よりリモートデスクトップが一番出来が良いです。

Linuxからリモートデスクトップ接続するときはxfreerdpを使います。便利なんですけど、オプションが独特すぎていつも書き方を忘れます。バージョン2系とバージョン3系で若干オプションが違いますが、今回は3系を紹介します。

xfreerdp3系のオプション例

$ xfreerdp3 \ /d: \ /v:remotehost:3389 \ /size:1920x1080 \ /kbd:layout:0x411 \ /clipboard:direction-to:all \ /auto-reconnect-max-retries:5 ### キーボードレイアウトの一覧を確認するには $ xfreerdp3 /list:kbd

いつも使っているオプションです。意味は下記のとおりです。

- /d:domain: 大抵はドメインを入れる必要がないので空白でOK

- /v:host:port: ホスト名、ポート番号(省略すると3389)

- /size:WxH: 画面サイズ

- /kbd:layout:0x411: 日本語配列キーレイアウト、これを忘れると英語配列になってしまう(一覧を見るなら/list:kbdオプション)

- /clipboard:direction-to:all: クリップボードを双方向(リモート←→ローカルどちら向きにも転送する)有効にする

- /auto-reconnect-max-retries:N: 切断されたときにリトライする回数

確か音声も転送できたはずですが、私はLinux側の音声は無視しているので音声関係のオプションは書いていません。こんなオプションが便利だよ、と教えていただけると喜びます。

コメント一覧

- コメントはありません。

この記事にコメントする

この記事にコメントする

2024年10月24日

ONKYOからM-AUDIOのUSB DACへ

目次: PC

かれこれ10年以上(2013年3月16日の日記参照)活躍してくれたONKYO SE-U33GXV2ですが、いよいよ調子が悪くなってきたようです。しばらく放っておくと音が出なくなってしまいます。

Windows 11のアップデート直後から発生するようになったので、Windows 11のせいである可能性もゼロではありません。が、同様の不具合に言及している人が見当たらないところを見ると、USB DACが故障した可能性の方が高いでしょう。

次のUSB DACはM-AUDIO M-Track Solo(メーカーのサイト)にしました。実はしばらく前に購入していたのに使わずに積んだままでした。活躍の場ができて良かったです。

M-Track Solo

入力が2系統(XLR/6.3mmステレオコンボプラグ: マイク/Line、6.3mmステレオプラグ: ギターなど/Line)、出力が2系統(RCAプラグ: スピーカー、3.5mmミニプラグ: ヘッドフォン)あります。ありがたいですね。

ボリュームつまみは大きくて見やすく、筐体の上部に付いています。私のように目線より下(机やPC筐体の上など)に置く人には、操作しやすくて良いです。一方でラックに入れて使う人にはやや使いづらいかもしれません。

動作も問題ないですね、変なノイズやおかしな音はしません。音質は良いんじゃないでしょうか、私の耳では細かいことは良くわかりませんけども……。

コメント一覧

- コメントはありません。

この記事にコメントする

この記事にコメントする

2024年10月21日

OpenPilotを調べる - プロセス間通信msgqの仕組み

目次: OpenPilot

最近はOSSの運転支援ソフトウェアOpenPilotのコードを見ています。今日はOpenPilotのプロセス間通信について調べます。

OpenPilotは複数のプロセスが共有メモリを通じてデータを送受信しています。データ送受信のモデルはPublisher/Subscriberモデルを採用していて、1つの通信チャネルについて1つだけPublisherがいてデータ送信役を担い、複数のSubscriberがいてデータ受信役を担います。Client/Serverモデルとは異なりデータはPublisherからSubscriberへの一方通行で、SubscriberからPublisherに送ることはできません。

Publisher/Subscriberの仕組みの名前が見当たらなかったので、関連するコードのディレクトリ(openpilot/cereal)からcerealと呼びます。画像用のPublisher/Subscriberの仕組みだけ特別にVisionIpc(openpilot/msgq/msgq/visionipc)と名前が付いていてcerealと実装が異なりますが、背後にあるデータ送受信の仕組みmsgq(openpilot/msgq)は共通です。

実装箇所

今回の着目点はmsgqですから、cerealとVisionIpcの違いは扱いません。簡単に双方ともmsgqを使う経路がある説明だけに留めます。

まずcerealです。cerealはPython用およびC++用のクラス定義を行っています。Publisher用がPubMaster、Subscriber用がSubMasterです。PythonもC++も同じクラス名で、クラス定義、実装箇所は下記のとおりです。

- Python用: openpilot/cereal/messaging/__init__.py

- C++用: openpilot/cereal/messaging/socketmaster.cc

背後のデータ送受信の仕組みはopenpilot/msgq/msgq/msgq.ccにあります。関数がプレフィクスmsgq_から始まるので見分けやすいです。cerealのPubMaster/SubMasterからmsgqのコードに至る経路は下記のとおりです。

cerealの実行経路の概要

PubMaster::PubMaster()

PubSocket::create()

MSGQPubSocket::connect()

msgq_new_queue()

SubMaster::SubMaster()

SubSocket::create()

MSGQSubSocket::connect()

msgq_new_queue()

次にVisionIpcのServer/Clientからmsgqのコードに至る経路は下記のとおりです。コンポーネントによって呼び出し元は違うので、例としてPublisher側はreplayのCameraServer、Subscriber側はuiのCameraWidgetからの経路を挙げます。

VisionIpcの実行経路の概要

CameraServer::startVipcServer()

VisionIpcServer::create_buffers_with_sizes()

PubSocket::create()

MSGQPubSocket::connect()

msgq_new_queue()

CameraWidget::vipcThread()

VisionIpcClient::VisionIpcClient()

SubSocket::create()

MSGQSubSocket::connect()

msgq_new_queue()

経路は多少違うもののcerealもVisionIpcも両方ともmsgqに行き着きます。ただしcerealはmsgq以外の経路(ZMQ)が選択可能で、ZMQを選択した場合は上記と異なる実行経路となります。

msgqのデータ共有方法

ファイルの共有メモリマップをお互いのプロセスから読み書きしてデータ共有します。msgq_new_queue()にて/dev/shmにあるtmpfsファイルシステム(メモリ上にファイルシステムを作る仕組み)上に1つの通信チャネルごとに1つファイルを作成します。1つのファイルをPublisherとSubscriberが共有メモリマッピングするので、お互いに同じファイルのデータが見えます。Publisherがメモリマップ経由でファイルを書き換えたらSubscriber全員に変更が見える仕組みです。

通常、ファイルの共有メモリマップに書き込んだ内容を他のプロセスに可視化するときはmsync()を呼ぶ必要があります。しかしmsgqの実装はtmpfs決め打ちというか、msync()の手間を惜しんだのか、atomicアクセスもしくはメモリバリア__sync_synchronize()だけで済ませています。うーん?これでも動くんだ……?

msgqの変更可視化の実装例(Publisher側のsend)

// openpilot/msgq_repo/msgq/msgq.cc

int msgq_msg_send(msgq_msg_t * msg, msgq_queue_t *q){

//...

//★★q->dataは共有メモリマップへのポインタ★★

char *p = q->data + write_pointer; // add base offset

//...

// Write size tag

//★★atomicアクセス★★

std::atomic<int64_t> *size_p = reinterpret_cast<std::atomic<int64_t>*>(p);

*size_p = msg->size;

// Copy data

//★★memcpy + メモリバリア★★

memcpy(p + sizeof(int64_t), msg->data, msg->size);

__sync_synchronize();

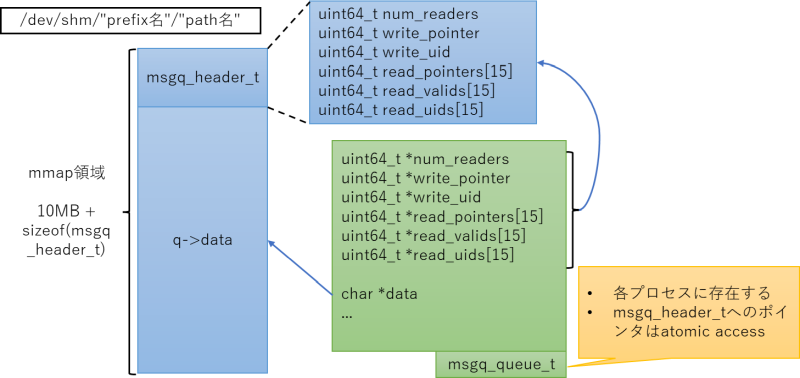

ファイル内のデータは下記のようにヘッダ領域とデータ領域の2領域からなります。各プロセスにはmsgq_queue_t構造体が確保され、ヘッダ領域とデータ領域へのポインタを保持します。

データ領域のサイズはDEFAULT_SEGMENT_SIZE(10MiB)固定です。Subscriber数の最大数はread_pointers[]などの配列長で決まります、現状だとNUM_READERS(15)固定です。なぜ16じゃなくて15なのか?理由が良くわかりません。特に理由は書いていませんでした。

msgqのデータ構造体(一部)

// openpilot/msgq_repo/msgq/msgq.h

#define DEFAULT_SEGMENT_SIZE (10 * 1024 * 1024)

#define NUM_READERS 15

#define ALIGN(n) ((n + (8 - 1)) & -8)

struct msgq_header_t {

uint64_t num_readers;

uint64_t write_pointer;

uint64_t write_uid;

uint64_t read_pointers[NUM_READERS];

uint64_t read_valids[NUM_READERS];

uint64_t read_uids[NUM_READERS];

};

struct msgq_queue_t {

std::atomic<uint64_t> *num_readers;

std::atomic<uint64_t> *write_pointer;

std::atomic<uint64_t> *write_uid;

std::atomic<uint64_t> *read_pointers[NUM_READERS];

std::atomic<uint64_t> *read_valids[NUM_READERS];

std::atomic<uint64_t> *read_uids[NUM_READERS];

char * mmap_p;

char * data;

size_t size;

int reader_id;

uint64_t read_uid_local;

uint64_t write_uid_local;

bool read_conflate;

std::string endpoint;

};

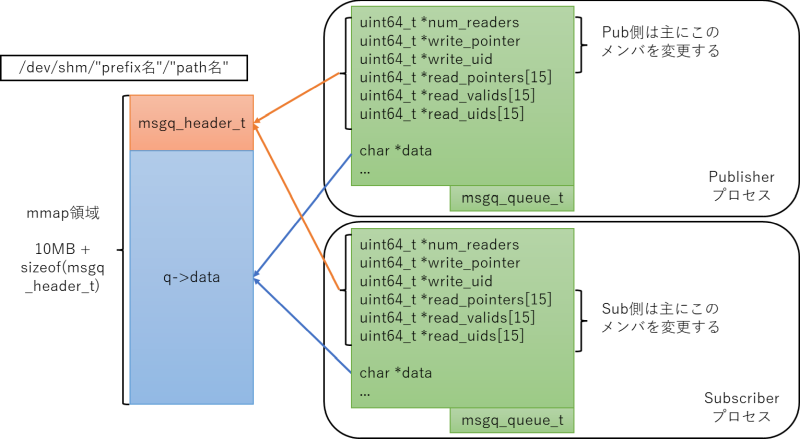

PublisherとSubscriberが1プロセスずついるときはこんな感じです。msgq_header_tの実体は1つで、各プロセスのmsgq_queue_tがmsgq_header_tとデータ領域へのポインタを保持します。

PublisherとSubscriber間のtmpファイル共有

データ領域はPublisherが書き手、Subscriberが読み手のリングバッファとして機能します。つまりPublisherはデータ領域に送信したいデータを書いてwrite_pointerを進め、Subscriberはデータ領域からデータを読み取ってread_pointerを進めます。

コメント一覧

- コメントはありません。

この記事にコメントする

この記事にコメントする

2024年10月20日

ゲームを買ったら遊びましょう2

目次: ゲーム

前回の振り返り(2022年5月13日の日記参照)から2年半経ちました。所持しているゲームのリストを見るとほとんど変わっていなくて、最近ゲームしてないことが良く表れてます。特に続編系は情熱をもって遊べていないですね。小規模ゲームはいくつかクリアしました。

- Skylines 2

- 順当な続編である印象を受けますね、システムは大体一緒です。リリース直後はゲームバランスが変で遊ばなくなりました。そのうち改善されるでしょう。

- スプラ3

- 初めから超絶ボコボコにされてやる気ゼロになりました。下手くそには辛い。

- Wizardry外伝

- 初期のWizardry目指して作った感じですかね?昔のWiz好きなら面白いと思います。追加シナリオ1個(戦闘の監獄、Prisoners of the Battles)をクリアしましたが、基本シナリオ5個全部クリアする元気はありませんでした。

- 熱血硬派くにおくん外伝

- くにおくんシリーズを裏切らない、たくさん出てくる敵をボコボコにしていくシステムで面白いです。が、私はアクションが基本的に好きではなくて、あまり続きませんでした。

- 8番出口

- 地下鉄の通路を思わせる道に起きた異変を察知しながら脱出を試みるゲームです。短いながら面白かったです。アイデアの勝利ですね。

振り返り結果

クリアした(実績90〜100%、シナリオコンプなど)。

- 332.9: Steam: Cities: Skylines

- 192.8: Steam: STATIONflow

- 180.3: Steam: Transport Fever 2

- 68.5: Steam: Mad Tower Tycoon

- 59.2: Steam: shapez.io

- 35.0: Switch: DUNGEON ENCOUNTERS

- 23.3: Steam: ぶきあつめ (The World is Your Wepon)

- 10.0: Switch: Return of the Obra Dinn

- 1.0: Switch: ごめんね、NPCです

- 1.0: Steam: 8番出口

たくさん遊んだ(クリア条件がないor困難すぎて挑む気なし)。

- 413.3: Steam: Dyson Sphere Program

- 170.0: Steam: the Hunter: Call of the Wild

- 95.0: Switch: スプラトゥーン2

未クリア(実績、シナリオクリア率が50%以下)。

- 71.5: Steam: Surviving Mars

- 63.9: Steam: Tropico 6

- 55.0: Switch: Fire Emblem風花雪月

- 44.4: Steam: Wizardry外伝 五つの試練

- 39.4: Steam: Timberborn

- 28.9: Steam: Cities: Skylines II

- 28.9: Steam: Turing Complete

- 21.5: Epic: DAEMON X MACHINA

- 20.0: Switch: ザ・コロニスト

- 15.0: Switch: マリオカート8デラックス

- 15.0: Switch: A列車で行こう はじまる観光計画

- 9.0: Steam: Freeways

ほぼ遊んでいない。

- 12.3: Steam: Asset Corsa

- 10.0: Switch: スイカゲーム

- 9.0: Steam: Captain of Industry

- 5.0: Switch: スプラトゥーン3

- 4.8: Steam: OpenTTD

- 4.0: Steam: Battlefield V

- 3.9: Steam: Kerbal Space Program

- 2.0: Switch: 熱血硬派くにおくん外伝 River City Girls 2

- 1.0: Steam: Plate Up!

メモ: 技術系の話はFacebookから転記しておくことにした。

コメント一覧

- コメントはありません。

この記事にコメントする

この記事にコメントする

| < | 2024 | > | ||||

| << | < | 10 | > | >> | ||

| 日 | 月 | 火 | 水 | 木 | 金 | 土 |

| - | - | 1 | 2 | 3 | 4 | 5 |

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 | - | - |

最近のコメント5件

最近の記事20件

-

25年11月28日

25年11月28日

すずき (12/04 02:17)

「[ジャガーさんの所感] 目次: 車ジャガーXE Sを購入してから4か月が経ちました。通勤で毎日乗っているためか走行距離が3,0...」 -

25年11月29日

25年11月29日

すずき (12/02 01:15)

「[バーベキュー@つくば] 筑波大関連の人が集まってバーベキューするイベントが年1回開かれていて、誘ってもらったので去年から参加...」 -

23年5月15日

23年5月15日

すずき (12/02 00:43)

「[車 - まとめリンク] 目次: 車三菱 FTO GPX '95の話。群馬県へのドライブ1群馬県へのドライブ2将来車を買い替え...」 -

25年9月7日

25年9月7日

すずき (12/01 22:03)

「[ジャガーXEのタイヤ交換(FALKEN AZENIS)] 目次: 車タイヤのメーカーが左前だけ違うのと、溝の残りが4mmくら...」 -

25年7月20日

25年7月20日

すずき (12/01 22:02)

「[ジャガーXEを買いました] 目次: 車車を買い替えました。ジャガーXE Sです。マイナー車すぎて会社の人たちもあまり知らなさ...」 -

10年9月3日

10年9月3日

すずき (12/01 22:01)

「[レガシィの納車は明日] 目次: 車中古車屋さんから夕方電話がかかってきました。明日の納車だそうです。担当の方が忙しいかったの...」 -

10年9月4日

10年9月4日

すずき (12/01 22:00)

「[今日の予定] 目次: 車今日の予定はこんな感じ。午前: 納車(茨木)昼: 退寮(高槻)午後: 同期のみなさんと食事(京都)実...」 -

25年11月21日

25年11月21日

すずき (12/01 21:55)

「[ジャガーさんをぶつけた] 目次: 車家の近所の狭い道で路駐してたタクシーをかわして進もうと思したら、左前を電柱にぶつけました...」 -

25年11月9日

25年11月9日

すずき (11/23 14:16)

「[タローマンのゲームTAS動画] 目次: ゲーム今年の夏ごろにシブヤフードダンジョンとタローマンがコラボしたイベント(シブヤフ...」 -

21年12月28日

21年12月28日

すずき (11/23 14:14)

「[ゲーム - まとめリンク] 目次: ゲームNintendo DSを買ったパネルでポンDS最近の朝はパネポンDS聖剣伝説DSチ...」 -

25年5月1日

25年5月1日

すずき (11/07 13:52)

「[首都高バトルSteam版、フルチューン後の姿 - その3] 目次: ゲーム首都高バトル(Steam版)高ランクの車をひたすら...」 -

23年4月10日

23年4月10日

すずき (11/04 16:20)

「[Linux - まとめリンク] 目次: Linuxカーネル、ドライバ関連。Linux kernel 2.4 for ARMが...」 -

09年5月18日

09年5月18日

すずき (11/04 16:19)

「[ffmpegとlibx264] 目次: LinuxせっかくDVDという長めの映像コンテンツが手元にあるので、ffmpegで変...」 -

25年10月31日

25年10月31日

すずき (11/02 03:19)

「[GNU global + pygmentsトラブルシューティングUbuntu編] 目次: Linux先日(2025年10月2...」 -

25年10月22日

25年10月22日

すずき (11/02 02:58)

「[NTPで時刻をすぐに合わせたい] 目次: LinuxNTPで時刻を調整する方法は2つあって、ズレている時間をジワジワ合わせて...」 -

23年6月1日

23年6月1日

すずき (11/02 02:42)

「[自宅サーバー - まとめリンク] 目次: 自宅サーバーこの日記システム、Wikiの話。カウンターをPerlからPHPに移植日...」 -

05年11月23日

05年11月23日

すずき (11/02 02:41)

「[NTPで時計合わせ、その2] 目次: 自宅サーバー11/23現在、未だGoogle先生に捕捉されていない奇跡。それはさておき...」 -

05年11月22日

05年11月22日

すずき (11/02 02:41)

「[NTPで時計合わせ] 目次: 自宅サーバーパソコンの時計は勝手にどんどんずれていきます。放って置くと1分くらいずれていること...」 -

15年5月8日

15年5月8日

すずき (11/02 02:40)

「[GPSは世界一正確な時計、その2] 目次: 自宅サーバー前回(2015年3月9日の日記参照)はGPSモジュールをPCと接続し...」 -

15年3月9日

15年3月9日

すずき (11/02 02:40)

「[GPSは世界一正確な時計] 目次: 自宅サーバーGPSのレシーバーモジュールを買いました。Globalsat BU-353S...」

こんてんつ

wiki

wiki Linux JM

Linux JM Java API

Java API過去の日記

2002年

2002年 2003年

2003年 2004年

2004年 2005年

2005年 2006年

2006年 2007年

2007年 2008年

2008年 2009年

2009年 2010年

2010年 2011年

2011年 2012年

2012年 2013年

2013年 2014年

2014年 2015年

2015年 2016年

2016年 2017年

2017年 2018年

2018年 2019年

2019年 2020年

2020年 2021年

2021年 2022年

2022年 2023年

2023年 2024年

2024年 2025年

2025年 過去日記について

過去日記についてその他の情報

アクセス統計

アクセス統計 サーバ一覧

サーバ一覧 サイトの情報

サイトの情報合計:

本日: